Có một sự thật rõ ràng là: một số điều không nên làm đã được thực hiện, bằng chứng là sự phẫn nộ của thế giới về sự thất bại của Cambridge Analytica/Facebook. Khi Google giải tán hội đồng đạo đức của mình chỉ một tuần sau khi được công bố, rất nhiều người đã có ý kiến về những điểm sai lầm ngay từ đầu của việc thành lập một ủy ban đạo đức. Những vấn đề được đặt ra như việc lựa chọn người tham gia ủy ban và liệu Google có thực sự cố gắng thành lập một ủy ban hay chỉ là một chiến lược tiếp thị, v.v…

Có một sự thật rõ ràng là: một số điều không nên làm đã được thực hiện, bằng chứng là sự phẫn nộ của thế giới về sự thất bại của Cambridge Analytica/Facebook. Khi Google giải tán hội đồng đạo đức của mình chỉ một tuần sau khi được công bố, rất nhiều người đã có ý kiến về những điểm sai lầm ngay từ đầu của việc thành lập một ủy ban đạo đức. Những vấn đề được đặt ra như việc lựa chọn người tham gia ủy ban và liệu Google có thực sự cố gắng thành lập một ủy ban hay chỉ là một chiến lược tiếp thị, v.v…

Trong khi đó, các tổ chức trên toàn cầu đang thảo luận về vấn đề thiết lập đạo đức cho trí tuệ nhân tạo và những gì được “tin tưởng” trong các hệ thống tự học. Tuy nhiên, để có thể ảnh hưởng đến đạo đức trí tuệ nhân tạo, nó phải được triển khai dưới dạng mã.

Briana Brownell, nhà khoa học dữ liệu và giám đốc tài chính của công ty công nghệ PureStrargety cho biết: “Những cá nhân đang làm việc trong lĩnh vực trí công nghệ chưa được đào tạo chính thức về đạo đức. Có phải con người đang mong đợi các nhà phát triển phần mềm luôn đặt vấn đề đạo đức khi thực hiện vai trò của mình, hay muốn có một vai trò đạo đức cụ thể trong tổ chức để xử lý những vấn đề đó? Giờ đây còn quá mơ hồ về những gì sẽ được thực hiện”.

Google đã sai ở đâu

Một số tổ chức đang thành lập các ủy ban đạo đức kết hợp các nhà khoa học hành vi, triết gia chuyên nghiệp, nhà tâm lý học, nhà nhân chủng học, chuyên gia quản lý rủi ro, nhà tương lai học và các chuyên gia khác. Điều lệ tập thể của ủy ban là giúp một công ty giảm thiểu khả năng xảy ra “kết quả không mong muốn” mà không phù hợp với điều lệ của công ty và điều lệ xã hội. Họ sẽ xem xét một cách thận trọng làm thế nào các hệ thống trí tuệ nhân tạo của công ty có thể được sử dụng, lạm dụng và cung cấp những hiểu biết mà các nhà công nghệ có thể sẽ thiếu.

Câu hỏi chính đặt ra là liệu các thành viên của ủy ban đạo đức có thể được coi là có đạo đức hay không. Người sáng lập công ty drone Dyan Gibbens và chủ tịch Quỹ Di sản Kay Coles James có chung mối quan tâm đặc biệt. Sự hiện diện của Gibbens đã tái hiện những lo ngại về việc quân đội sử dụng công nghệ của Google. James được biết đến vì đã lên tiếng chống lại quyền của cộng đồng LGBT (Cộng đồng những người đồng tính luyến ái nữ, đồng tính luyến ái nam, song tính luyến ái và Hoán tính).

Phillip Alvelda, giám đốc điều hành và là người sáng lập Brainworks, cựu giám đốc dự án của Cơ quan Dự án Nghiên cứu Quốc phòng Hoa Kỳ (DARPA) ) và cựu nhà khoa học tên lửa của NASA cho biết: “Một trong những thách thức cốt lõi khi bạn thành lập ủy ban này chính là các khía cạnh đạo đức nào bạn muốn thể hiện trên bảng điều khiển. Theo quan điểm của tôi là mặc dù Google đã có những nỗ lực có chủ ý để định hướng lãnh đạo với suy nghĩ sâu sắc, xem xét các khía cạnh đạo đức và làm cho nó trở thành một phần của quá trình phát triển sản phẩm. Nhưng cuối cùng họ đã vướng vào một cuộc chiến về những nền tảng đạo đức đúng đắn của những người tham gia vào ủy ban đạo đức

Công ty cung cấp những giải pháp thực thi pháp luật Axon là một trong những công ty đầu tiên thành lập ủy ban đạo đức trí tuệ nhân tạo. Mặc dù mong muốn thực sự của công ty là mang lại những ảnh hưởng tích cực, 42 tổ chức đã ký một bức thư ngỏ tới ủy ban đạo đức của Axon nhấn mạnh sự cần thiết của khía cạnh đạo đức liên quan đến sản phẩm (thiết kế có đạo đức), cần phải xem xét việc sử dụng sản phẩm (sử dụng có đạo đức) và nhu cầu về các bên liên quan khác nhau, bao gồm cả những người sẽ bị ảnh hưởng nhiều nhất bởi công nghệ (kết quả có đạo đức).

Ủy ban đạo đức trí tuệ nhân tạo không phải là một ý tưởng tồi. Vấn đề ở chỗ đạo đức trí tuệ nhân tạo là một chủ đề mới, chính vì vậy nó đang thể hiện các triệu chứng thị trường sớm.

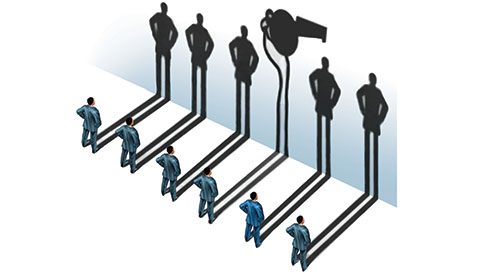

Những người tố giác đang lộ diện

Christopher Wylie, người làm việc tại SCL Group, công ty mẹ của Cambridge Analytica, là một trong số những người tố giác đã tiết lộ chiến dịch tranh cử tổng thống Mỹ năm 2016 trên Facebook. Thật thú vị, anh cũng là người đã đưa ra kế hoạch thu thập dữ liệu Facebook để tạo hồ sơ tâm lý và chính trị của từng thành viên.

Jack Poulson, cựu nhà khoa học nghiên cứu của Google, là một trong năm nhân viên của Google đã chống lại Project Dragonfly, một công cụ tìm kiếm di động bị kiểm duyệt mà Google đang tạo mẫu cho thị trường Trung Quốc. Dự án Maven gây ra những làn sóng phản đối thậm chí còn lớn hơn khi 3.100 nhân viên của Google đã ký một lá thư phản đối việc Bộ Quốc phòng Hoa Kỳ sử dụng dữ liệu từ những máy bay không người lái (drone) của Google. Trong vụ việc này, hơn một chục nhân viên đã xin nghỉ việc.

Amy Webb, Giám đốc điều hành của Viện nghiên cứu Future Today, giáo sư tại Trường Kinh doanh Stern của Đại học New York, và là tác giả của cuốn sách: “Làm thế nào những người khổng lồ công nghệ và bộ máy suy nghĩ của họ có thể cảnh báo loài người” cho biết: “Tôi cho rằng có một số người muốn nói ra sự thật sẽ cảm thấy công việc của họ sẽ gặp nguy hiểm. Trong các trường hợp khác, mọi người sẽ cảm thấy tự do hơn, thoải mái hơn hoặc có động lực để nói ra suy nghĩ của mình. Tôi nghĩ rằng thực tế bây giờ có rất nhiều người từ các công ty công nghệ lớn viết bài đăng trên blog và phát biểu tại các hội nghị để thể hiện quan điểm của mình”.

Ngay bây giờ, những vấn đề về đạo đức của trí tuệ nhân tạo đang ở trạng thái non trẻ. Và không có gì đáng ngạc nhiên khi hầu hết các công ty đang thử nghiệm nó hoặc có những triển khai ở giai đoạn đầu. Tuy nhiên, các nhà công nghệ, các nhà hoạch định chính sách, giáo sư, nhà triết học và những chuyên gia khác đang giúp thúc đẩy những nghiên cứu về đạo đức trí tuệ nhân tạo, được thực hiện bởi Viện nghiên cứu Future of Life, Diễn đàn Kinh tế Thế giới và Viện Kỹ sư Điện và Điện tử (IEEE). Trên thực tế, các tiêu chuẩn, khung, chương trình chứng nhận và các dạng tài liệu giáo dục khác nhau đang xuất hiện một cách nhanh chóng.

Điều gì sẽ xảy ra tiếp theo?

Các đạo luật và quy định sẽ xuất hiện, mặc dù sẽ không nhanh chóng như Quy định bảo vệ dữ liệu chung (GDPR) của EU và Đạo luật bảo mật người tiêu dùng California (CCPA), cả hai đều được thiết kế cho thời đại thuật toán.

Hiện tại, các nhà phát triển phần mềm và lãnh đạo của họ cần tự quyết định xem họ coi trọng điều gì và họ đã sẵn sàng làm những gì vì điều đó, khi chưa có những tuân thủ về đạo đức trí tuệ nhân tạo.

Alvelda đến từ Brainwork cho biết: “Nếu công ty của bạn đang thiết kế một cái gì đó, quy tắc của bạn là gì, hướng dẫn đạo đức và quy trình hoạt động của bạn để đảm bảo rằng những gì bạn phát triển sẽ duy trì đạo đức của công ty như thế nào? Khi bạn đang xây dựng một cái gì đó phải thể hiện một số khía cạnh đạo đức, bạn áp dụng công nghệ, máy móc và thực hành phát triển nào để đảm bảo những gì bạn xây dựng thực sự phản ánh những gì công ty dự định? Tất cả những điều này nằm trong một môi trường rộng lớn hơn, nơi bạn phải tự hỏi liệu nó có phù hợp với đạo đức của cộng đồng và thế giới nói chung như thế nào?”.

Các nhà thiết kế và nhà phát triển nên tìm hiểu và nỗ lực tạo ra trí tuệ nhân tạo có đạo đức, để tránh những kết quả phi đạo đức. Tuy nhiên, các nhà công nghệ không thể kích hoạt đạo đức trí tuệ nhân tạo một mình, vì nó cần sự hỗ trợ của toàn bộ hệ sinh thái. Trong một công ty, đó là việc duy trì các giá trị từ phòng họp đến bộ phận sản xuất. Bên ngoài một tổ chức, các nhà đầu tư và cổ đông phải biến đạo đức trí tuệ nhân tạo thành điều kiện tiên quyết để đầu tư. Và người tiêu dùng phải biến đạo đức trí tuệ nhân tạo thành vấn đề thương hiệu. Cho đến lúc đó, các công ty và cá nhân có thể tự do làm những gì họ muốn trừ khi và cho đến khi tòa án, các nhà lập pháp và cơ quan quản lý cùng hợp tác khi một sự kiện bất lợi lớn xảy ra (đó là điều mà nhiều chuyên gia trí tuệ nhân tạo mong đợi).

Các nhà phát triển nên suy nghĩ về đạo đức trí tuệ nhân tạo ngay bây giờ, vì nó sẽ trở thành một phần của thực tế của họ trong tương lai không xa. Đã có một số công cụ được sử dụng, và có lẽ một số sản phẩm và dịch vụ được xây dựng bao gồm các yếu tố tự học. Trong khi các nhà phát triển không chịu trách nhiệm về trí tuệ nhân tạo có đạo đức, thì trách nhiệm sẽ phát sinh khi có vấn đề xảy ra và đòi hỏi phải biết ai đã xây dựng thứ đó ngay từ đầu.