Sự trỗi dậy của trí tuệ nhân tạo tối

AI tối đề cập đến việc triển khai cục bộ hoặc từ xa các mô hình ngôn ngữ lớn (LLM) không bị hạn chế trong một khuôn khổ đầy đủ hoặc hệ thống chatbot, được sử dụng cho các mục đích độc hại, phi đạo đức hoặc trái phép.

Các hệ thống này hoạt động ngoài các biện pháp kiểm soát an toàn, tuân thủ hoặc quản trị tiêu chuẩn, thường cho phép các khả năng như lừa đảo, thao túng, tấn công mạng hoặc lạm dụng dữ liệu mà không có sự giám sát.

AI tối đang hoạt động

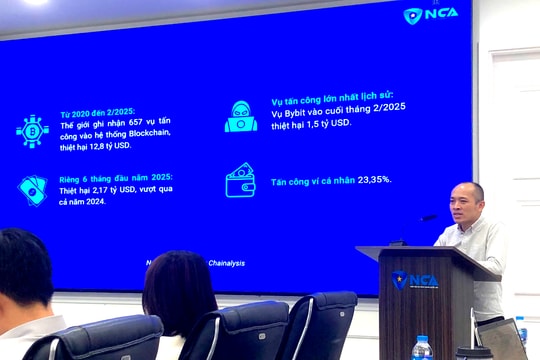

Kể từ khi ChatGPT trở nên phổ biến toàn cầu vào năm 2023, Kaspersky đã nhận thấy một số ứng dụng hữu ích của AI, từ các tác vụ thông thường như tạo video đến phát hiện và phân tích mối đe dọa kỹ thuật. Đồng thời, những kẻ xấu cũng đang sử dụng nó để tăng cường khả năng tấn công của chúng.

Ông Sergey Lozhkin, Trưởng nhóm Nghiên cứu và phân tích toàn cầu (GReAT) phụ trách khu vực META (Brazil, Bolivia, Guatemala, Paraguay, Philippines và Vương quốc Anh) và các nước châu Á - Thái Bình Dương (APAC) tại Kaspersky, cho biết chúng ta đang bước vào kỷ nguyên an ninh mạng và trong xã hội, nơi AI là lá chắn và AI tối là thanh kiếm.

Ông Lozhkin chia sẻ rằng việc sử dụng AI độc hại phổ biến và nổi tiếng nhất hiện nay là dưới dạng GPT mũ đen (black hat), xuất hiện sớm nhất là vào giữa năm 2023. Đây là những mô hình AI được xây dựng, sửa đổi hoặc sử dụng có chủ đích để thực hiện các hoạt động phi đạo đức, bất hợp pháp hoặc độc hại như tạo mã độc, tạo email lừa đảo trôi chảy và thuyết phục cho cả các cuộc tấn công hàng loạt và có mục tiêu, tạo deepfake giọng nói và video, và thậm chí hỗ trợ các hoạt động của Red Team (đội đỏ), nhóm chuyên gia an ninh mạng độc lập.

GPT mũ đen có thể là các mô hình AI riêng tư hoặc bán riêng tư. Các ví dụ đã biết bao gồm WormGPT, DarkBard, FraudGPT và Xanthorox, được thiết kế hoặc điều chỉnh để hỗ trợ tội phạm mạng, gian lận và tự động hóa độc hại.

Các tác nhân quốc gia tận dụng LLM trong các chiến dịch

Bên cạnh những ứng dụng đen tối điển hình của AI, ông Lozhkin tiết lộ các chuyên gia Kaspersky hiện đang quan sát thấy một xu hướng đen tối hơn - các tác nhân quốc gia tận dụng LLM trong các chiến dịch của họ.

"OpenAI gần đây đã tiết lộ họ đã phá vỡ hơn 20 tác động bí mật và các hoạt động mạng đang cố gắng lạm dụng các công cụ AI của mình. Chúng ta có thể dự đoán các tác nhân đe dọa sẽ tạo ra nhiều cách thông minh hơn để vũ khí hóa AI tạo sinh hoạt động trong cả hệ sinh thái đe dọa công cộng và tư nhân. Chúng ta nên chuẩn bị cho điều đó", ông giải thích.

Báo cáo của Open AI tiết lộ các tác nhân độc hại đã sử dụng LLM để tạo ra những nhân vật giả mạo rất thuyết phục, phản hồi mục tiêu theo thời gian thực và tạo ra nội dung đa ngôn ngữ được thiết kế để lừa nạn nhân và vượt qua các bộ lọc bảo mật truyền thống.

"AI không phân biệt đúng sai, nó là một công cụ làm theo lời nhắc. Ngay cả khi có các biện pháp bảo vệ, chúng ta vẫn biết rằng APT là những kẻ tấn công dai dẳng. Khi các công cụ AI đen ngày càng dễ tiếp cận và hiệu quả hơn, điều quan trọng đối với các tổ chức và cá nhân ở châu Á - Thái Bình Dương là tăng cường an ninh mạng, đầu tư vào phát hiện mối đe dọa được hỗ trợ bởi chính AI và luôn cập nhật kiến thức về cách thức khai thác những công nghệ này", ông Lozhkin chia sẻ thêm.

Để giúp các tổ chức tự bảo vệ mình trước AI tối và các mối đe dọa mạng được hỗ trợ bởi AI, chuyên gia của Kaspersky cho rằng cần sử dụng các giải pháp bảo mật thế hệ tiếp theo như Kaspersky Next để phát hiện phần mềm độc hại và các mối đe dọa do AI hỗ trợ trong chuỗi cung ứng; Sử dụng các công cụ tình báo mối đe dọa theo thời gian thực để giám sát các cuộc tấn công khai thác do AI gây ra./.