Tấn công lừa đảo sử dụng AI tăng vọt hơn 2000%

Một báo cáo của Signicat và Consult Hyperion cho thấy deepfake hiện chiếm 6,5% tổng số vụ lừa đảo, đánh dấu mức tăng kỷ lục 2137% trong 3 năm qua.

Một báo cáo mới đây của công ty nhận dạng kỹ thuật số Signicat và công ty tư vấn Consult Hyperion đã tiết lộ một xu hướng đáng báo động: Hơn một 1/3 các nỗ lực lừa đảo nhắm vào các tổ chức tài chính hiện sử dụng AI và trong số đó 29% đã thành công.

Báo cáo đã khảo sát 1.206 người làm việc tại các tổ chức tài chính trên 7 quốc gia châu Âu, bao gồm cả Bỉ. Kết quả cho thấy 38% tổn thất do gian lận mà các tổ chức tài chính gặp phải là bởi cuộc tấn công sử dụng trí tuệ nhân tạo (AI). Trong đó, gian lận danh tính đã tăng 80% trong 3 năm qua, với gian lận do AI hỗ trợ và đặc biệt là việc sử dụng các kỹ thuật deepfake đang nổi lên như một “mối đe dọa đáng kể”.

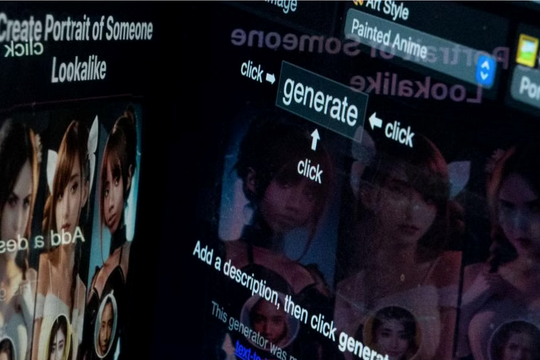

Có thể thấy, công nghệ deepfake sử dụng AI để tạo các video và hình ảnh giả mạo ngày càng trở nên phổ biến. Mặt trái của công nghệ này đang khiến các nhà quản lý an ninh mạng trên khắp thế giới lo ngại, đặc biệt là về hiện tượng lừa đảo tài chính.

Chiếm đoạt tài khoản

Báo cáo của Signicat tiết lộ một thay đổi đáng lo ngại trong chiến thuật mà những kẻ lừa đảo sử dụng. Ba năm trước, AI chủ yếu được sử dụng để tạo danh tính tổng hợp mới và giả mạo tài liệu.Ngày nay, AI đang được sử dụng rộng rãi ở quy mô lớn hơn để thực hiện các cuộc tấn công mạng. Cụ thể, deepfake hiện chiếm 6,5% tổng số vụ lừa đảo, đánh dấu mức tăng đáng kinh ngạc 2137% trong 3 năm qua.

Chiếm đoạt tài khoản, từng được coi là vấn đề chủ yếu của người tiêu dùng, hiện đã trở thành loại gian lận phổ biến nhất đối với các tổ chức, doanh nghiệp. Theo đó, những kẻ lừa đảo khai thác mật khẩu yếu hoặc được sử dụng lại để xâm phạm các tài khoản hiện có, thậm chí sử dụng deepfake để mạo danh chủ tài khoản.

Deepfake và những con số

Deepfake là công nghệ ứng dụng AI để tạo ra các sản phẩm công nghệ âm thanh, hình ảnh và video làm giả đối tượng ngoài đời thực với độ chính xác rất cao. Dựa trên tệp tin hình ảnh khuôn mặt, giọng nói của một người ngoài đời thực, deepfake sẽ sử dụng thuật toán để tái tạo lại khuôn mặt và giọng nói phù hợp với nét mặt, biểu cảm của một người khác; sau đó tạo ra video giả mạo hoàn toàn đối tượng ngoài đời thực.

Thông qua mạng Internet, các đối tượng thu thập hình ảnh, giọng nói của người dùng trên mạng xã hội, sử dụng công nghệ deepfake tạo ảnh động, video giả mạo người dùng đang nói chuyện trực tuyến với cùng khuôn mặt, âm điệu giọng nói và cách xưng hô.

Khi công nghệ AI ngày càng phát triển thì việc phát hiện, phân biệt giữa nội dung thật và giả trên không gian mạng sẽ trở nên khó khăn hơn. Bởi vậy, bất kỳ ai cũng có thể trở thành mục tiêu, nạn nhân tấn công mạng sử dụng deepfake.

Theo báo cáo năm ngoái của Diễn đàn Kinh tế thế giới (WEF), lĩnh vực ngân hàng đặc biệt lo ngại về các cuộc tấn công deepfake, với 92% người lo lắng về gian lận deepfake.

Nhiều công ty trên thế giới đã thiệt hại hàng triệu USD khi trở thành nạn nhân trong những vụ lừa đảo có sử dụng deepfake. Vào năm 2023, 26% công ty nhỏ và 38% công ty lớn đã gặp phải gian lận deepfake dẫn đến thiệt hại lên tới 480.000 USD.

Tuy nhiên, gian lận deepfake không chỉ là vấn đề đối với các công ty nhỏ. Năm ngoái, Cơ quan quản lý tài chính Anh (FCA) đã gióng lên hồi chuông cảnh báo về những rủi ro liên quan đến gian lận deepfake.

Giám đốc điều hành FCA, Nikhil Rathi, tuyên bố rằng AI có thể phá vỡ lĩnh vực dịch vụ tài chính theo “những cách và ở quy mô chưa từng thấy trước đây”.

Điển hình là vụ việc công ty thiết kế và kỹ thuật đa quốc gia Arup của Anh đã vướng vào một vụ lừa đảo deepfake nhắm vào một trong những nhân viên của họ ở Hồng Kông và khiến người này mất 25 triệu USD. Theo cảnh sát, nhân viên này đã bị lừa tham gia một cuộc gọi điện video với những người mà anh ta tin là giám đốc tài chính và các nhân viên khác, nhưng tất cả đều là sản phẩm "thay mặt" của deepfake.

Vụ việc này cho thấy sự phức tạp và tác động tiềm ẩn của các cuộc tấn công deepfake đối với ngay cả những tổ chức lớn nhất.

Triển khai các biện pháp ngăn chặn gian lận do AI hỗ trợ

Báo cáo của Signicat nhấn mạnh rằng khoảng 3/4 các tổ chức cho rằng việc thiếu chuyên môn, thời gian và ngân sách là những nguyên nhân cản trở khả năng phát hiện và giải quyết các vấn đề của họ.

Giám đốc điều hành Signicat Asger Hattel cho biết AI sẽ trở nên “ngày càng tinh vi” và những người ra quyết định ngăn chặn gian lận “cần chuyên môn và nguồn lực để ngăn nó trở thành mối đe dọa lớn”.

"Gian lận luôn là một trong những mối lo ngại lớn nhất của khách hàng của chúng tôi và gian lận do AI hỗ trợ hiện đang trở thành mối đe dọa mới đối với họ", ông Asger Hattel nói, đồng thời kêu gọi các doanh nghiệp triển khai các giải pháp phòng ngừa đa lớp, kết hợp cả công nghệ và con người để tạo ra một hệ thống bảo mật toàn diện và linh hoạt nhằm ngăn chặn gian lận do AI.

Phát hiện deepfake

Trong thời gian tới, những kẻ lừa đảo sẽ tiếp tục tận dụng sức mạnh AI để thực hiện các hoạt động gian lận một cách thông minh hơn và deepfake đang trở thành một mối đe dọa thực sự nguy hiểm.

Đối mặt với thách thức này, các công ty và tổ chức tài chính cần tiếp cận vấn đề từ nhiều góc độ khác nhau để giảm thiểu rủi ro.

Công ty bảo mật Kaspersky đã từng chia sẻ một số giải pháp để người dùng tự bảo vệ mình khỏi các trò lừa đảo deepfake như nhận diện sự chuyển động không khớp giữa khuôn miệng và lời thoại, sử dụng phần mềm phát hiện nội dung do AI tạo ra để phân tích và xác định mức độ bị chỉnh sửa của tệp hình ảnh, video, âm thanh,...

Khi công nghệ AI tiếp tục phát triển thì các hình ảnh, âm thanh và video deepfake được tạo ra ngày càng tinh vi và khó phát hiện hơn.

Tuy nhiên, công nghệ AI có thể tạo ra deepfake cũng có thể được sử dụng để ngăn chặn nó. Các hệ thống AI có thể được đào tạo để phát hiện những điểm bất thường và mâu thuẫn tinh vi để chỉ ra một hành vi giả mạo, giúp tăng cường khả năng phòng thủ chống lại mối đe dọa mới nổi này.

Chẳng hạn, McAfee và Intel đã hợp tác để phát triển một công cụ phát hiện video giả mang tên Deepfake Detector. Deepfake Detector sử dụng những tính năng như phát hiện âm thanh để phát hiện những khác biệt tinh tế trong video thực và video do AI tạo ra.

Nhưng ngoài việc sử dụng AI để phát hiện deepfake, các tổ chức cần phải triển khai các quy trình mạnh mẽ để ngăn chặn hành vi này ở cấp độ cá nhân, theo công ty an ninh mạng Avast, bởi đây thường là mắt xích yếu nhất trong chuỗi bảo mật./.

.jpg)

.jpg)