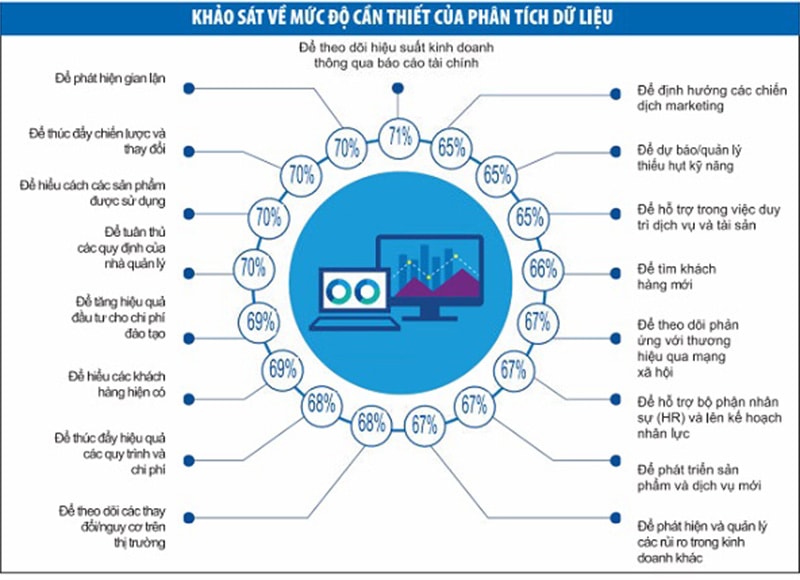

Trong vài năm trở lại đây, phân tích dữ liệu là nhân tố trung tâm được sử dụng nhằm khám phá các nguồn tăng trưởng mới, tăng cường năng suất và quản lý rủi ro.

Phạm Đỗ Nhật Vinh - Giám đốc Dịch vụ tư vấn tài chính, KPMG Việt Nam

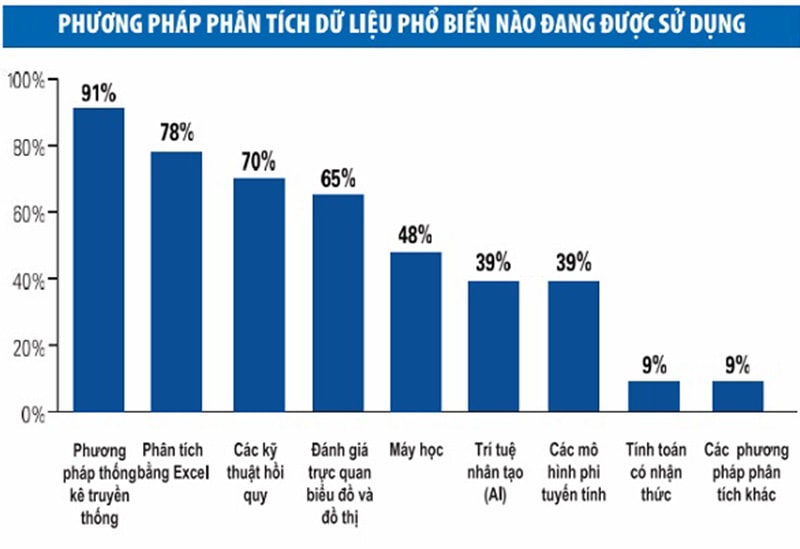

Các ngân hàng ở Việt Nam đã và đang thử nghiệm các kỹ thuật phân tích dữ liệu trong nhiều hoạt động như tìm kiếm khách hàng, cấp tín dụng, cung cấp sản phẩm, bán chéo, kiểm soát gian lận... Nhiều hình thức phân tích khác nhau được áp dụng, từ các cách thức truyền thống cho tới những cách thức dựa trên thời gian thực, học máy hay các kỹ thuật tiên tiến khác cho nhiều mục đích đa dạng trong hoạt động ngân hàng.

Thuật ngữ “dữ liệu lớn”, “trí tuệ nhân tạo”, “học máy”… được nhắc đến như một xu thế tất yếu cần đầu tư. Thậm chí cũng có những suy nghĩ rằng, các phương pháp phân tích mô hình truyền thống đang lỗi thời và cần thay thế bởi các kỹ thuật tiên tiến, hiện đại.

Tuy nhiên, chúng ta cũng nên nhìn nhận một cách thực tế về mức độ tin cậy/mức độ hoài nghi về kết quả đem lại từ phân tích dữ liệu ở các ngân hàng hiện nay đang như thế nào? Đầu tư vào các dự án “big bang” và ứng dụng ngay các kỹ thuật tiên tiến có đem đến lợi ích như kỳ vọng?

Bài viết xin được chia sẻ những góc nhìn được đúc rút từ kết quả khảo sát toàn cầu gần đây của KPMG với nhiều ngân hàng và các nhà lãnh đạo cấp cao trên thế giới và một số quan điểm của KPMG về chủ đề này.

Tồn tại khoảng trống niềm tin

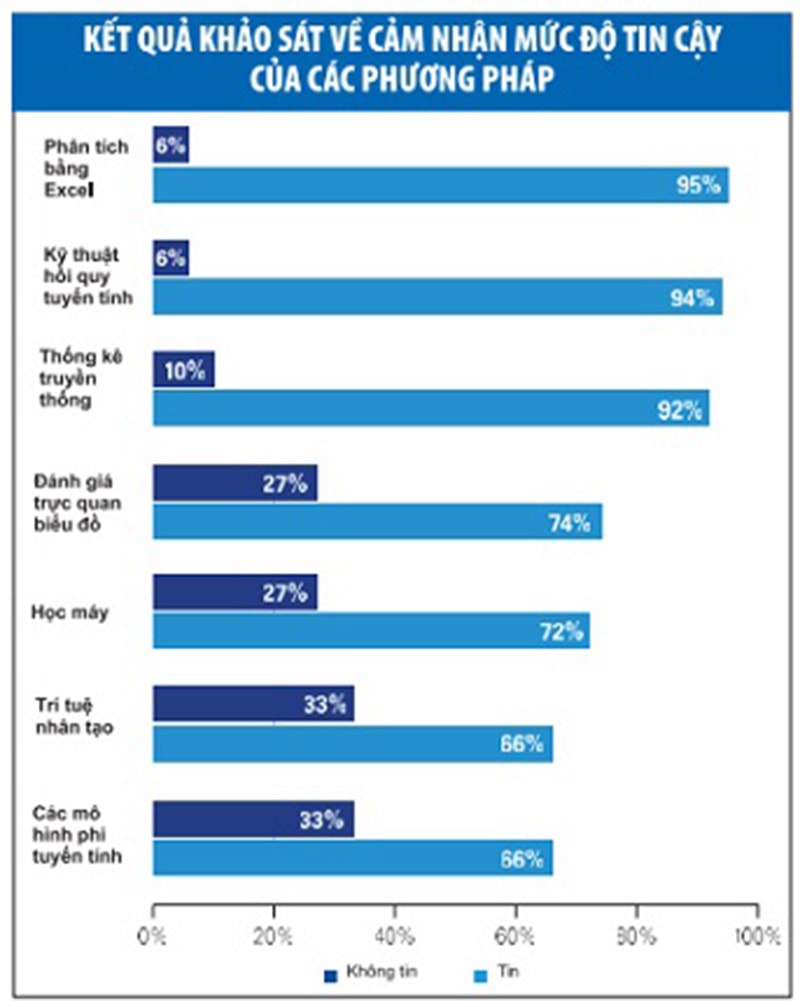

Nghiên cứu của chúng tôi cho thấy, giám đốc điều hành của các ngân hàng thất vọng với việc mất bao lâu để có được những thông tin chi tiết, hữu ích từ kết quả phân tích dữ liệu lớn và trí tuệ nhân tạo. Và họ cũng không tự tin về kết quả nhận được. Họ không nhận được những đánh giá sâu sắc như kỳ vọng. Họ phải chờ quá lâu để có kết quả và khi nhận được chúng, họ phải vất vả để tìm ra ý nghĩa. Kết quả là, các nhà lãnh đạo doanh nghiệp mất niềm tin vào phân tích nâng cao và các chuyên gia dữ liệu mà họ tuyển dụng, nên quay lại với các phương pháp phân tích quen thuộc.

Trên 2.000 tổ chức toàn cầu đã tham gia một cuộc điều tra và thực tế cho thấy, khoảng 60% tổ chức chia sẻ rằng, họ không thực sự tự tin với kết quả từ phân tích dữ liệu. Chỉ khoảng 10% tin rằng, họ đã quản lý được chất lượng phân tích dữ liệu. Chỉ 13% tổ chức cho biết, họ đã kiểm soát được các vấn đề liên quan đến quyền riêng tư và các yếu tố đạo đức khi sử dụng phân tích dữ liệu và chỉ 16% cho là đã đảm bảo được độ chính xác của các mô hình phân tích.

Trong quá trình làm việc với các ngân hàng, chúng tôi nhận thấy, bên cạnh thách thức lớn là chất lượng dữ liệu, nhiều lãnh đạo cảm thấy không chắc chắn hiểu đúng về cách vận hành của những kỹ thuật tiên tiến mà được ví như những chiếc “hộp đen”. Đây cũng là một phần nguyên nhân mà 70% số tổ chức được khảo sát cho rằng, sử dụng phân tích dữ liệu sẽ ảnh hưởng đến rủi ro danh tiếng như việc vi phạm quy định liên quan đến dữ liệu, bảo mật thông tin, bán sai sản phẩm/dịch vụ (mis-selling)…

Những lãnh đạo tham gia khảo sát có quan điểm ít tin tưởng vào các kỹ thuật phân tích tiên tiến, chẳng hạn như trí tuệ nhân tạo và học máy. Các phương pháp mà họ tin tưởng là bảng tính Excel và các kỹ thuật thống kê truyền thống như tương quan và hồi quy. 65% cho biết, họ nhìn vào các biểu đồ và đồ thị để đánh giá các đặc điểm và xu hướng.

Điều gây phiền phức nhất là kết quả chậm

Có lẽ, điều gây khó chịu nhất đối với giám đốc điều hành các ngân hàng là thời gian cần phải có để nhận được đánh giá chuyên sâu từ việc phân tích dữ liệu. Gần một nửa (48%) số người được hỏi nói rằng, phải mất hơn 4 tháng để chuyển từ một ý tưởng phân tích ban đầu cho tới khi có được những kết quả sâu sắc. Trong một vài trường hợp, phản hồi về thời gian chờ đợi này có thể là 1 năm, thậm chí lâu hơn. Khi được hỏi về sự đánh đổi giữa tốc độ và độ chính xác, 90% người được hỏi cho biết, họ muốn có một phân tích trong 6 tuần mà độ chính xác là 90%, hơn là đợi 6 tháng để có được độ chính xác 95%, hoặc 1 năm với độ chính xác 99,99%.

Khuyến nghị của KPMG

Xây dựng niềm tin bắt đầu từ một mô hình mục tiêu phù hợp

Để phát triển niềm tin vào các phương pháp mới và đặt ra những kỳ vọng hợp lý, trước tiên, những người ra quyết định cần có những hiểu biết căn bản và dần quen thuộc về cách thức hoạt động của công nghệ. Các chương trình đào tạo, trao đổi nên được thiết kế để nâng cao nhận thức, giúp các lãnh đạo cấp cao cảm thấy tin tưởng với các công cụ và phương pháp mới.

Bộ phận phân tích dữ liệu cần được thiết kế và kiểm nghiệm nhằm đảm bảo đây phải là một tập hợp những cán bộ có kỹ năng công nghệ thông tin và kỹ năng khoa học dữ liệu, được hoạt động gắn kết và tương tác với các bộ phận kinh doanh để từ đó đưa ra những sáng kiến phục vụ mục đích và chiến lược của tổ chức. Bằng cách tổ chức này, các lãnh đạo thu nhận được những kết quả tin cậy hơn để đưa ra các quyết định quan trọng. Kết quả là, khoảng trống niềm tin được thu hẹp.

Chọn cách làm nhanh, linh hoạt, nhưng hiệu quả cao hơn

Trong một xu thế chuyển đổi số mạnh mẽ, các ngân hàng hiểu rằng, họ cần những hiểu biết sâu sắc mà có thể cần đến các phương pháp nâng cao. Tuy nhiên, không phải lúc nào họ cũng đủ thời gian chờ đợi cho đến khi các phương pháp này mang lại kết quả. Một số công ty đã tạo ra các hệ thống tốn kém và quá phức tạp, trong khi các giải pháp đơn giản hơn có thể là giải pháp thay thế. Cách tiếp cận “giết gà bằng dao mổ trâu” như vậy sẽ gây ra nhiều phiền phức và tốn kém hơn là ích lợi đem lại.

Không phải tất cả các vấn đề đều cần đến các dự án lớn về phân tích dữ liệu và các vấn đề phức tạp không phải lúc nào cũng cần các giải pháp công nghệ phức tạp. Theo kinh nghiệm của chúng tôi, thay vì xây dựng những dự án lớn, hãy bắt đầu với một vấn đề cụ thể, sử dụng cách tiếp cận linh hoạt và từng bước mở rộng quy mô, các công ty vẫn có thể có được những phân tích chuyên sâu để hỗ trợ đưa ra quyết định nhanh chóng.

Từ việc sử dụng các tập dữ liệu nhỏ với các phương pháp phân tích truyền thống và thoải mái với độ tin cậy 90%, nhiều vấn đề có thể được giải quyết trong vài tuần, chứ không cần đến vài tháng. Với cách tiếp cận Agile như vậy, các dự án được chia thành các giai đoạn công việc ngắn, tập trung hoàn thành nhanh hơn và với chất lượng cao hơn so với phương pháp “thác nước” truyền thống (waterfall), là những phương pháp cố gắng đưa đến những kết quả đồ sộ (“big bang”).