Sử dụng AI giả mạo hình ảnh, giọng nói để chiếm đoạt tài sản

Theo cảnh báo từ Cục An toàn thông tin, Bộ Thông tin và Truyền thông, nhiều người đã trở thành nạn nhân của các cuộc lừa đảo tài chính sử dụng deepfake và trí tuệ nhân tạo (AI).

Chiêu thức lừa đảo sử dụng công nghệ deepfake, AI

"Ngay cả khi bạn thực hiện một cuộc gọi video và thấy mặt người thân hay bạn bè, nghe đúng giọng nói của họ thì cũng không hẳn bạn đang nói chuyện với chính người đó", báo cáo từ Cục ATTT cho biết.

Mới đây, một nhân viên văn phòng tại Hà Nội đã trở thành nạn nhân của chiêu trò lừa đảo trên. Theo chia sẻ từ N.T.H., trong một lần trò chuyện với bạn thông qua ứng dụng Facebook Messenger, người bạn của H. đã chào và kết thúc câu chuyện.

Tuy nhiên, người bạn này đột nhiên quay lại nhắn tin, hỏi vay tiền và đề nghị chuyển tiền vào một tài khoản ngân hàng. Dù tên tài khoản trùng khớp với tên của bạn mình, H. vẫn thoáng nghi ngờ nên yêu cầu gọi video để xác thực.

Người bạn đồng ý nhưng cuộc gọi chỉ kéo dài vài giây do "mạng chập chờn". Khi thấy mặt bạn mình trong cuộc gọi video, giọng nói cũng đúng của người này, H. không còn nghi ngờ và chuyển tiền.

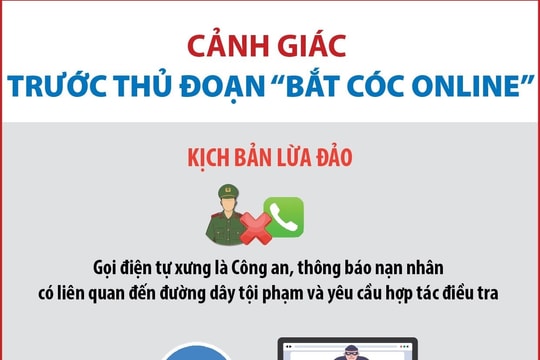

Vài năm trở lại đây, hiện tượng lừa đảo chiếm đoạt tài sản thông qua mạng xã hội (MXH) ngày càng phổ biến. Các đối tượng lừa đảo sử dụng nhiều thủ đoạn, chiêu trò như giả danh các cơ quan chức năng, nhân viên ngân hàng, lừa đảo trúng thưởng, hack tài khoản Facebook, Zalo hoặc các tài khoản MXH khác nhắn tin cho người thân, bạn bè của chủ tài khoản để lừa đảo chiếm đoạt tài sản.

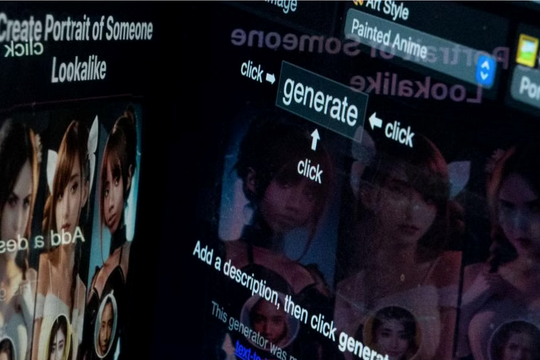

Tuy nhiên, gần đây xuất hiện một loại thủ đoạn tinh vi hơn được các đối tượng lừa đảo sử dụng đó là deepfake. Đây là một loại công nghệ có thể mô phỏng khuôn mặt con người, cho phép người dùng có thể tạo ra những hình ảnh, đoạn video giả mạo gần giống với người thật. Nhiều người dùng mạng xã hội đã bị lừa tiền bởi đoạn video, cuộc gọi video hay đoạn hội thoại giả mạo người thân được tạo ra từ công nghệ này.

Xuất hiện lần đầu tiên vào năm 2017, deepfake chỉ đơn thuần là công cụ ghép mặt người này vào người khác, tuy nhiên, đến nay, deepfake đã bị lợi dụng trở thành công cụ cho các phi vụ lừa đảo.

Việc deepfake ngày càng phát triển cùng với việc thao tác video được tự động hóa sẽ tạo ra nhiều mối đe dọa đối với xã hội vì việc thao túng hình ảnh ngày càng trở nên dễ dàng hơn. Đây sẽ là cơ hội cho các đối tượng lừa đảo thực hiện các hành vi của mình một cách tinh vi hơn, đặc biệt là lừa đảo trong hoạt động ngân hàng để chiếm đoạt tài sản.

Nhận diện các thủ đoạn lừa đảo qua công nghệ deepfake trong hoạt động ngân hàng để đưa ra giải pháp phòng, tránh tốt nhất, hạn chế những rủi ro là điều rất quan trọng và cấp thiết trong bối cảnh hiện nay.

Biện pháp phòng tránh

Về biện pháp phòng tránh, đại diện Cục ATTT khuyến cáo, trước nguy cơ cả hình ảnh và giọng nói đều có thể làm giả mạo, người dân phải luôn có ý thức xác minh; đừng vội truy cập bất kỳ đường link nào để đề phòng nguy cơ bị hack tài khoản ngân hàng, tài khoản mạng xã hội; hạn chế sự hiện diện trên MXH, hoặc đặt tài khoản của mình ở chế độ riêng tư, chỉ chấp nhận yêu cầu từ những người tin tưởng để phòng ngừa, ngăn chặn việc dữ liệu hình ảnh, âm thanh của mình bị sao chép.

Người dân tuyệt đối không đưa lên mạng các thông tin như số căn cước công dân, địa chỉ nhà riêng, ngày sinh, số điện thoại, tên của con cái...

Bên cạnh đó, nếu nhận được các cuộc gọi đe doạ tống tiền bằng hình ảnh hay video nhạy cảm, người dân cần bình tĩnh, xác minh và tìm hiểu kĩ nguồn gốc của hình ảnh, video. Đồng thời, người dân cần nâng cao nhận thức về những vấn đề an toàn không gian mạng, tìm hiểu các dấu hiệu nhận biết về hình thức lừa đảo AI để tránh bị sập bẫy chiếm đoạt tài sản hay lộ lọt thông tin cá nhân phục vụ vào mục đích xấu.

Người dân không nên truy cập vào các địa chỉ website lạ, không cài đặt các phần mềm lạ không rõ nguồn gốc, những phần mềm đòi hỏi yêu cầu cấp quyền truy cập cao vào thông tin người dùng, truy cập thẻ nhớ, danh bạ, vị trí, chụp ảnh,…

Ngoài ra, nếu bị làm giả deepfake hay lừa đảo trực tuyến nói chung, người dùng nên thông báo ngay lập tức cho mọi người biết và báo cơ quan công an tại nơi cư trú.

Để ngăn chặn các cuộc tấn công lừa đảo qua deepfake cần phải có sự chung tay từ Nhà nước, các tổ chức, ngân hàng đến người dân. Để có thể nhận diện và hạn chế những rủi ro phát sinh từ thủ đoạn lừa đảo do các đối tượng sử dụng công nghệ deepfake tạo ra, cần lưu ý một số nội dung sau:

Một là, tiếp tục nâng cao nhận thức của người dân về những thủ đoạn và rủi ro có thể phát sinh từ công nghệ deepfake. Nhận thức chính là một công cụ phòng, tránh mạnh mẽ. Khi nhận thức về vấn đề lừa đảo thông qua sử dụng AI được xây dựng tốt thì người dân sẽ nâng cao ý thức cảnh giác và kẻ lừa đảo sẽ rất khó có thể dụ dỗ. Các thông tin về những thủ thuật lừa đảo phải được cập nhật thường xuyên và chính xác nhất để người sử dụng phát hiện ra những cái bẫy đáng ngờ.

Hai là, sử dụng xác minh sinh trắc học. Sinh trắc học thường sử dụng các đặc điểm độc nhất trên cơ thể để xác minh như: Dấu vân tay, mống mắt...

Ba là, tiếp tục nâng cao trình độ khoa học, công nghệ, đưa ra những giải pháp công nghệ có thể phát hiện ra video, hình ảnh do Deepfake tạo ra, sử dụng chính các công cụ AI mà deepfake sử dụng để phát hiện và ngăn chặn các sản phẩm giả mạo của chính nó.

Bốn là, tiếp tục xây dựng và hoàn thiện khung hành lang pháp lý đối với công nghệ AI, trong đó có deepfake. Hiện nay, nhiều nước trên thế giới đã ban hành những đạo luật để phòng, chống deepfake như Hoa Kỳ, Trung Quốc.../.