AI có thể giải quyết mọi vấn đề?

Với mọi tiến bộ thực sự trong lĩnh vực “trí tuệ nhân tạo”, chúng ta thấy sự gia tăng song song giữa cường điệu, lầm tưởng, quan niệm sai lầm và thông tin không chính xác. Những hiểu lầm này góp phần tạo nên sự mờ ám của các hệ thống trí tuệ nhân tạo (AI), khiến chúng trở nên kỳ diệu, khó hiểu và khó có thể tiếp cận được trong mắt công chúng.

Bất cứ khi nào chúng ta nghe nói rằng hệ thống AI yêu cầu lượng dữ liệu khổng lồ hoặc những thứ liên quan đến điều đó, chúng ta đang nói về một cách tiếp

cận AI, cụ thể là học máy (ML), dựa trên quyền truy cập vào lượng lớn dữ liệu huấn luyện để thuật toán “học” các quy tắc. Sự gia tăng mức độ phổ biến gần đây của AI, bắt đầu từ năm 2012 trên thực tế, là sự gia tăng mức độ phổ biến của ML. Các cách tiếp cận khác, cũ hơn đối với AI, chẳng hạn như “hệ thống chuyên gia”, không yêu cầu dữ liệu đào tạo vì chúng được các chuyên gia “lập trình” một cách tỉ mỉ.

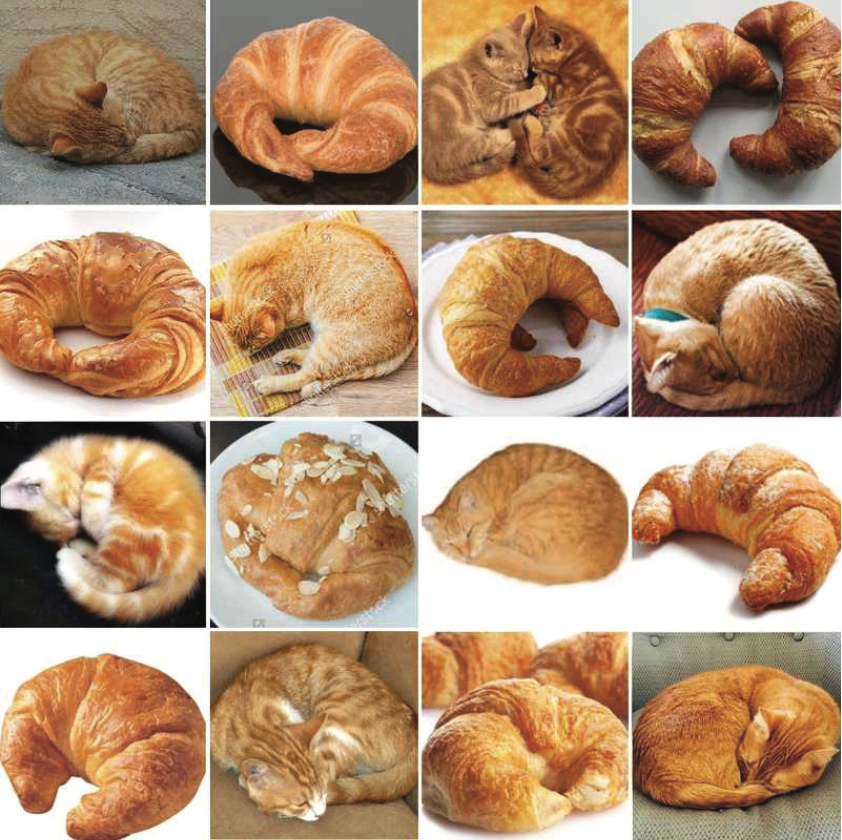

Điều làm cho ML trở nên độc đáo ở đây là hệ thống phải được cung cấp dữ liệu để có thể “huấn luyện” nó nhằm tạo ra những khác biệt hoặc phân loại nhất định. Chúng ta có thể thấy được một thách thức thường khó khăn đối với hệ thống ML trong việc phân biệt các hình ảnh bên dưới: hình ảnh nào chụp mèo và hình ảnh nào là bánh sừng bò?

Các câu hỏi khác mà chúng ta có thể muốn hệ thống ML trả lời có thể là:

- Hình ảnh này có chứa khuôn mặt không?

- Mọi người muốn xem bộ phim nào tiếp theo?

- Làm cách nào chúng ta có thể tự động hoàn thành câu hiện đang được người sử dụng nhập?

Để có thể trả lời bất kỳ câu hỏi nào trong số này, hệ thống ML cần được đào tạo về các tập dữ liệu lớn, thường được gắn nhãn thủ công, bởi công việc nhân công này sẽ tốn ít chi phí. Đối với bài toán phân biệt hình ảnh bánh sừng bò - con mèo, điều chúng ta thường cần là một tập dữ liệu lớn, được gắn nhãn gồm các hình ảnh có nhãn “con mèo” và các hình ảnh có nhãn “bánh sừng bò” để hệ thống học hỏi.

Thật vậy, nếu chúng ta đã từng lãng phí năm phút trong cuộc đời khi nhấp vào “các ô có đèn giao thông” để vượt qua CAPTCHA (Bài kiểm tra Turing công cộng hoàn toàn tự động để phân biệt máy tính và con người) trên một trang web, thì chính là chúng ta đã tự mình thực hiện công việc gán nhãn cho chính bạn.

Do hệ thống ML yêu cầu lượng dữ liệu khổng lồ để đào tạo, chúng ta thường nghe thấy những lời yêu cầu loại bỏ các hạn chế đối với việc thu thập và sử dụng dữ liệu để sự đổi mới ML có thể phát huy hết tiềm năng của nó. Nhưng việc truy cập dữ liệu không hạn chế như vậy, có thể tác động đến mức nào? Hệ thống ML có thể giải quyết bất kỳ vấn đề nào với đủ dữ liệu không, hay có những giới hạn cứng nào mà phương pháp ML chắc chắn sẽ gặp phải không?

Nếu chúng ta quay lại ví dụ về việc phân biệt hình ảnh con mèo với bánh sừng bò, thì việc “giải quyết vấn đề” phân biệt con mèo với bánh sừng bò có thể được thực hiện bằng cách cung cấp đủ lượng dữ liệu liên quan vào mô hình học máy phù hợp. Nếu chúng ta có một tập dữ liệu khổng lồ với hình ảnh những con mèo và bánh sừng bò từ mọi góc độ có thể tưởng tượng được, thì về lý thuyết, mô hình ML của chúng ta sẽ trở thành một con át chủ bài tuyệt đối trong việc phân biệt cái này với cái kia.

ML có thể làm tốt điều gì?

Tuy nhiên, có nhiều nhiệm vụ mà hệ thống máy học với độ chính xác cao có thể tạo ra sự khác biệt thực sự cho cuộc sống của chúng ta. Một mặt, có những nhiệm vụ mà khi con người thực hiện sẽ có xu hướng khá tệ, chẳng hạn như xem qua một lượng lớn văn bản hoặc đoạn phim video để đo lường sự xuất hiện của một số từ hoặc đối tượng nhất định. Mặt khác, có những nhiệm vụ mà con người có thể làm khá tốt, nhưng vì lý do này hay lý do khác không phải là loại nhiệm vụ mà chúng ta muốn làm. Điều này có thể là do chúng lặp đi lặp lại hoặc nhàm chán.

Để làm ví dụ về một nhiệm vụ lặp đi lặp lại, chúng ta có thể lấy ví dụ về dịch thuật ngôn ngữ. Mặc dù có nhiều người là chuyên gia dịch thuật và phần lớn chúng ta đều có khả năng học ngoại ngữ nhưng tất cả chúng ta đều được hưởng lợi từ các công cụ như Google dịch - một công cụ có thể cung cấp ngay lập tức các bản dịch có chất lượng tương đối tốt.

Học máy cũng hữu ích trong việc tự động hóa các nhiệm vụ mà

mọi người có xu hướng cảm thấy khó chịu hoặc kinh hoàng. Một ví dụ đáng chú ý, đã gây sự tò mò vào đầu năm 2020 khi một nhóm nghiên cứu tại Stanford đào tạo một hệ thống máy học để nhận

dạng “dấu hậu môn” của mọi người để có thể theo dõi việc sử dụng nhà vệ sinh nhằm theo dõi sức khỏe của họ. Đó là một nhà vệ sinh thông minh - nhưng không phải loại tự mở nắp để chuẩn bị sử dụng. Nhà vệ sinh này được trang bị công nghệ có thể phát hiện nhiều dấu hiệu bệnh tật trong phân và nước tiểu, bao gồm cả dấu hiệu của một số bệnh ung thư, chẳng hạn như ung thư đại trực tràng hoặc ung thư tiết niệu. Thiết bị này có thể đặc biệt hấp dẫn đối với những người có gen di truyền dễ mắc một số bệnh nhất định, chẳng hạn như hội chứng ruột kích thích, ung thư tuyến tiền liệt hoặc suy thận và muốn duy trì sức khỏe tốt nhất.

Rõ ràng là hầu hết mọi người sẽ cảm thấy khá khó chịu khi phải học cách nhận biết bệnh tật bằng “dấu hậu môn” và xác minh danh tính của họ theo cách này mỗi khi họ đi vệ sinh. Tuy nhiên, như nhiều người đã chỉ ra trong phản hồi, rất may có nhiều phương pháp xác minh danh tính ít xâm lấn hơn, chẳng hạn như dấu vân tay.

Giới hạn của học máy

Chúng ta có thể thấy, có nhiều cách mà kỹ thuật học máy có thể sử dụng các bộ dữ liệu lớn để giúp con người thực hiện một số nhiệm vụ nhất định. Tuy nhiên, điều này không có nghĩa là nếu chúng ta có đủ dữ liệu, chúng ta sẽ có thể đào tạo các hệ thống học máy để giải quyết bất kỳ vấn đề nào, cũng như bản thân kỹ thuật học máy phù hợp với mọi vấn đề. Trong nghiên cứu về cách nhận biết AI vô giá trị của GS. Arvind Narayanan của trường Stanford chứng minh những hạn chế của ML bằng cách đề xuất rằng chúng ta nên phân biệt giữa ba loại vấn đề mà ML đang được sử dụng để giải quyết.

Đầu tiên là vấn đề về nhận thức. Điều quan trọng ở đây là có một số sự thật cơ bản (ground truth) ngăn cản việc đo lường độ chính xác (tất nhiên sẽ không bao giờ chính xác là 100%, nhưng càng chính xác càng tốt). Ví dụ: khi chuyển lời nói thành văn bản, chúng ta có thể nói điều gì đó gần như chắc chắn trong khi đó văn bản được chuyển thể thành chính xác.

Tương tự, trong các nhiệm vụ nhận dạng khuôn mặt, hệ thống phải xác định xem hai bức ảnh có phải của cùng một người hay không (điều này được gọi là xác định hoặc nhận dạng một người nào đó từ một hình ảnh kỹ thuật số hoặc một khung hình video từ một nguồn video. Một trong những cách để thực hiện điều này là so sánh các đặc điểm khuôn mặt chọn trước từ hình ảnh và một cơ sở dữ liệu về khuôn mặt, để đảm bảo khớp 1-1), liệu chúng ta có thể nói chắc chắn hệ thống đưa ra dự đoán chính xác hay không. Như Narayanan nói, đối với loại vấn đề này, “khi được cung cấp đủ dữ liệu và tính toán, AI sẽ tìm hiểu các mẫu để phân biệt khuôn mặt này với khuôn mặt khác”.

Ở đây, chúng ta đã chứng kiến sự tiến bộ thực sự trong những năm gần đây và chính với loại vấn đề này, với ý tưởng “AI có thể giải quyết mọi vấn đề với đủ dữ liệu” ít nhất cũng có cơ sở. Tất nhiên, sức mạnh tính toán và số lượng dữ liệu là không đủ vì chất lượng dữ liệu là yếu tố then chốt, cùng với tất cả sự phức tạp của việc thiết kế và tinh chỉnh các thuật toán.

Mọi thứ trở nên phức tạp hơn rất nhiều trong loại vấn đề tiếp theo mà Narayanan gọi là vấn đề tự động hóa phán đoán. Những gì chúng ta cần làm ở đây là cố gắng để hệ thống ML học cách chúng ta đưa ra những đánh giá bằng cách cung cấp đủ số lượng ví dụ cho nó.

Ví dụ trong việc phát hiện thư rác, nếu chúng ta đào tạo hệ thống ML trên tập dữ liệu chứa hàng trăm nghìn email, một số được đánh dấu là “thư rác”, số khác là “không phải thư rác” thì ý tưởng là thuật toán sẽ học cách tạo ra sự khác biệt giống như chúng ta đã thực hiện. Trong trường hợp phát hiện thư rác, độ chính xác có thể đạt đến mức khá cao. Điều này phần lớn là do thường không có sự bất đồng nghiêm trọng nào về yếu tố cấu thành email spam.

Loại vấn đề cuối cùng mà Narayanan đề cập đến là dự đoán kết quả xã hội. Vấn đề ở đây là chúng ta đang xử lý những hệ thống có những hậu quả xã hội nghiêm trọng và những khái niệm cơ bản gây tranh cãi. Quan trọng nhất, các hệ thống này đang cố gắng dự đoán tương lai và đây là điểm khác biệt chính với vấn đề tự động hóa phán đoán.

Như đã lưu ý ở trên, việc đào tạo một hệ thống ML để xác định “tài liệu hay” không phải là một vấn đề có thể giải quyết được, bởi vì các tiêu chí đánh giá không thể được xác định rõ ràng. Đồng thời, ngay cả một vấn đề nan giải như phê bình văn học về cơ bản cũng chỉ đề cập đến quá khứ: sách đã xuất bản, và hệ thống sẽ chỉ phân loại theo tiêu chí.

Việc đưa ra các dự đoán xã hội, chính là một sự kết hợp vấn đề về tiêu chí gây tranh cãi với vấn đề đưa ra dự đoán về các sự kiện trong tương lai mà không có thông tin đầy đủ. Ví dụ về vấn đề này đã được Narayanan liệt kê trong việc dự đoán khả năng tái phạm tội, dự đoán nguy cơ khủng bố, dự đoán chính sách, dự đoán hiệu suất công việc và dự đoán trẻ em có nguy cơ cần can thiệp xã hội. Tất cả những vấn đề này đều liên quan đến việc dự đoán tương lai, điều mà ông cho rằng phải là điều mà chúng ta không tin có thể thực hiện được với ML trong những trường hợp sử dụng nghiêm trọng như vậy, nhưng lưu ý “dường như chúng ta đã quyết định tạm dừng những lý lẽ thông thường khi có liên quan đến AI”.

Các nhà hoạch định chính sách thường dựa vào công việc của các nhà khoa học xã hội để dự đoán các chính sách cụ thể có thể ảnh hưởng như thế nào đến kết quả xã hội như tỷ lệ việc làm hoặc tội phạm. Ý tưởng là nếu họ có thể hiểu các yếu tố khác nhau có thể thay đổi quỹ đạo cuộc sống của một ai đó như thế nào, họ có thể đề xuất các biện pháp can thiệp để đạt được kết quả tốt nhất.

Tuy nhiên, trong những năm gần đây, họ ngày càng dựa vào học máy, hứa hẹn sẽ đưa ra những dự đoán chính xác hơn nhiều bằng cách xử lý lượng dữ liệu lớn hơn nhiều. Những mô hình như vậy hiện được sử dụng để dự đoán khả năng bị cáo có thể bị bắt vì tái phạm tội lần thứ hai hoặc khả năng một đứa trẻ có nguy cơ bị lạm dụng và bỏ bê ở nhà. Giả định là một thuật toán được cung cấp đủ dữ liệu về một tình huống nhất định sẽ đưa ra dự đoán chính xác hơn con người hoặc phân tích thống kê cơ bản hơn.

Một ví dụ điển hình về việc dự đoán kết quả xã hội là một nghiên cứu gần đây, Nghiên cứu về Gia đình và Trẻ em dễ bị tổn thương, được công bố trên Kỷ yếu của Viện Hàn lâm Khoa học Quốc gia Mỹ, đã thu thập một lượng dữ liệu khổng lồ về cái gọi là “gia đình mong manh” và tổ chức một cuộc thi để xem liệu các nhà nghiên cứu có thể dự đoán sáu “kết quả cuộc sống” cho trẻ em, cha mẹ và hộ gia đình hay không. Các nhà nghiên cứu đã được cung cấp gần 13.000 điểm dữ liệu về hơn 4.000 gia đình.

Đối với các chuyên gia nghiên cứu việc sử dụng AI trong xã hội, kết quả không có gì đáng ngạc nhiên. Alice Xiang, người đứng đầu nghiên cứu về tính công bằng và trách nhiệm giải trình tại Tổ chức phi lợi nhuận Quan hệ đối tác về AI cho biết, ngay cả những thuật toán đánh giá rủi ro chính xác nhất trong hệ thống tư pháp hình sự cũng đạt tối đa 60% hoặc 70%. Cô nói thêm: “Về mặt tóm tắt thì có lẽ điều đó nghe có vẻ ổn,” nhưng dù sao thì tỷ lệ tái phạm cũng có thể thấp hơn 40%. Điều đó có nghĩa là việc dự đoán không tái phạm sẽ giúp bạn có tỷ lệ chính xác hơn 60%.

Tương tự, một nghiên cứu khác của Julia Dressel và Hany Farid cho thấy hệ thống dự đoán tái phạm tội phạm khét tiếng, COMPAS, “không chính xác hoặc công bằng hơn những dự đoán được đưa ra bởi những người có ít hoặc không có chuyên môn về tư pháp hình sự”. Họ cũng chứng minh “mặc dù có bộ sưu tập ấn tượng gồm 137 đặc điểm, nhưng có vẻ như một bộ phân loại tuyến tính chỉ dựa trên 2 đặc điểm - tuổi và tổngsốlầnkếtántrướcđó-làtấtcảnhữnggì cần thiết để mang lại độ chính xác dự đoán giống như COMPAS. Trong cả hai trường hợp, chúng tôi thấy rằng các thuật toán ưa thích và tập dữ liệu khổng lồ không tạo ra sự khác biệt nào về độ chính xác và khả năng dự đoán”.

AI - hay cụ thể hơn là các công nghệ dựa trên máy học - có những công dụng và ưu điểm nhất định nhưng cũng tiềm ẩn những rủi ro nhất định. Chúng ta không thể mong đợi chúng giải quyết được tất cả các vấn đề của chúng ta và bất kỳ ai xây dựng chính sách công đều phải nhận thức được việc sử dụng những công nghệ này có thể dẫn đến tác hại của chính họ. Bởi vậy nên cẩn trọng hơn trong việc đánh giá tính chính xác của các công cụ thuật toán một cách minh bạch.

Tài liệu tham khảo:

1. https://www.aimyths.org/

2. https://www.theguardian.com/

3. https://med.stanford.edu/news/...

(Bài đăng ấn phẩm in Tạp chí TT&TT số 1+2, tháng 1/2024)